随着 AI 的广泛影响,越来越多的企业在考虑是否可以接入 AI ,结合内部业务需求,实现一些落地场景。目前市面上有着很多的 AI 应用和形形色色、各种各样的开源 AI 系统,对于不了解 AI 的技术、非技术人员来说,怎么去学习了解、搭建 demo 是很困难的。因此,本文旨在以简单的方式帮助读者快速搭建两个 AI 系统,读者可以在使用两个系统后,更加深入了解 WebUI、大模型等相关的概念,以及可以知道目前的大语言模型可以做什么,怎么进行二次开发。

one-api

one-api 是用于集合各种模型,然后统一转换为 open ai 格式的接口,读者可以点击官方源码仓库了解更多:

https://github.com/songquanpeng/one-api

one-api 的作用是支持各种大厂的 AI 接口,比如 Open ai、百度文心等,然后在 one-api 上创建一层新的、与 open ai 一致的接口,这样依赖,AI 应用只需要支持 open ai 即可,不必再去对接各家的 ai 接口。

下载官方仓库:

git clone https://github.com/songquanpeng/one-api.git.

├── bin

├── common

├── controller

├── data

├── docker-compose.yml

├── Dockerfile

├── go.mod

├── go.sum

├── i18n

├── LICENSE

├── logs

├── main.go

├── middleware

├── model

├── one-api.service

├── pull_request_template.md

├── README.en.md

├── README.ja.md

├── README.md

├── relay

├── router

├── VERSION

└── webone-api 需要依赖 redis、mysql ,在 docker-compose.yml 配置文件中有详细的配置,同时 one-api 默认管理员账号密码为 root、123456,也可以在此修改。

执行 docker-compose up -d 开始部署 one-api。

然后访问 3000 端口,进入管理系统。

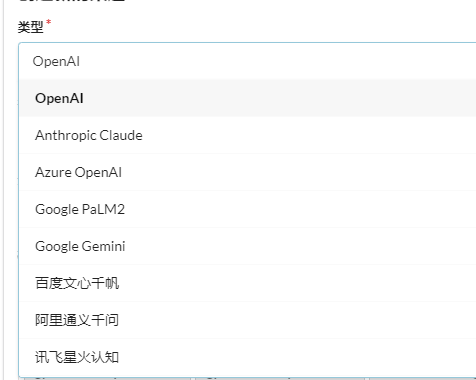

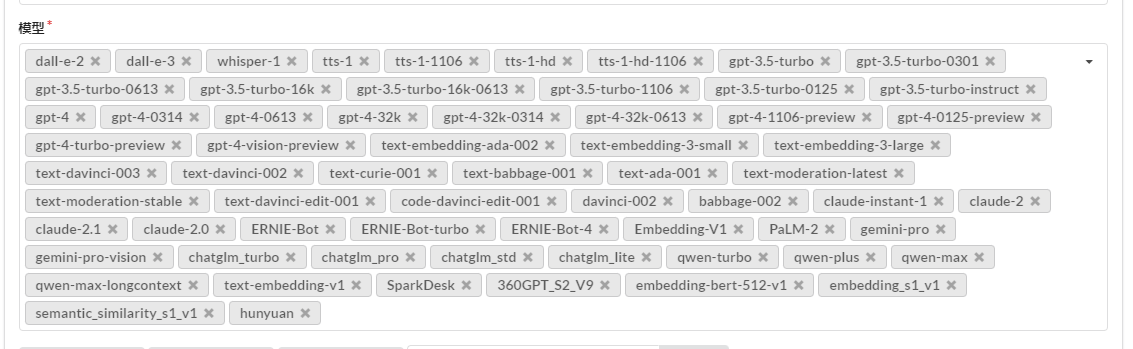

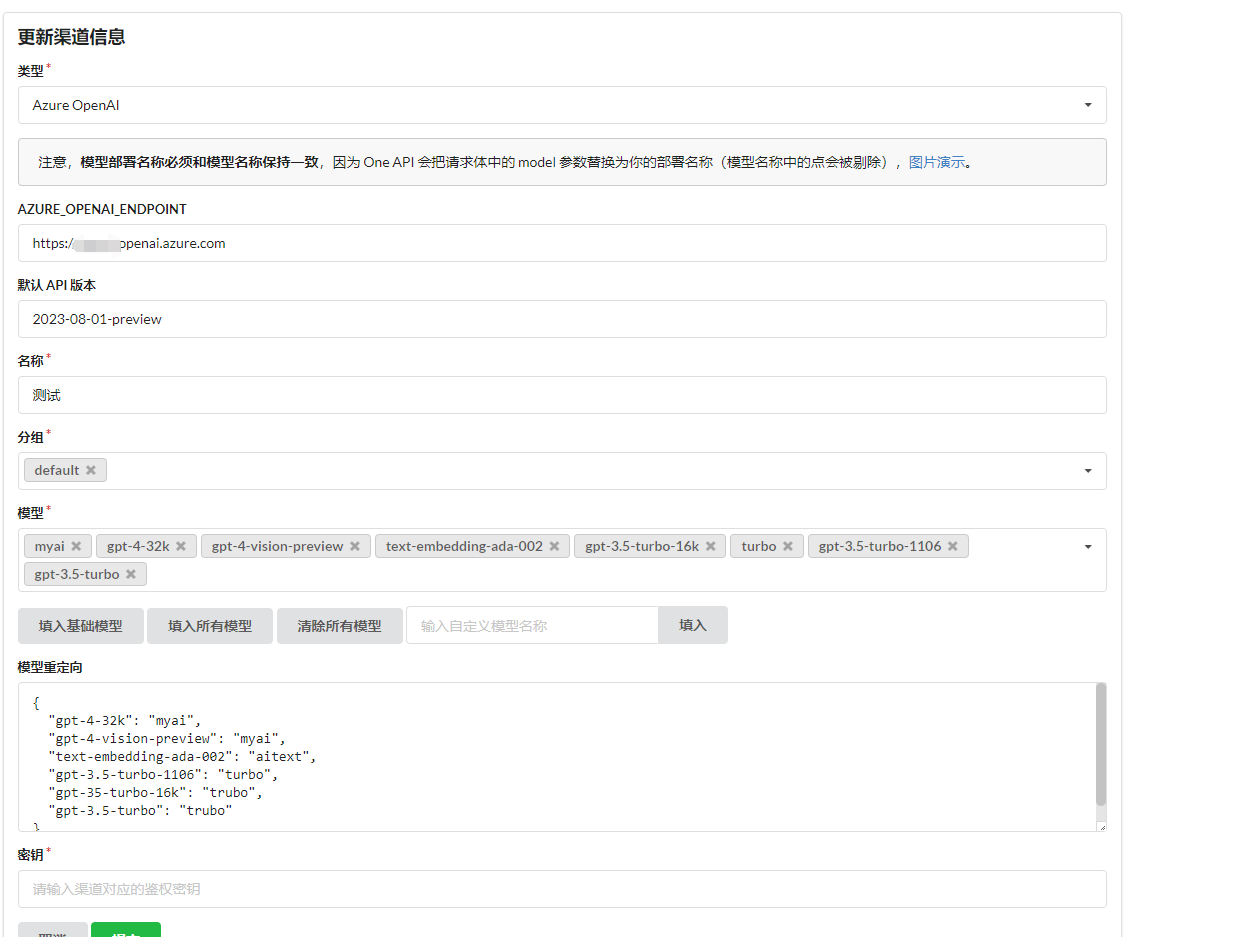

进入系统后,首先创建渠道,用于接入大厂的 AI 。

为什么有模型重定向和自定义模型呢。

比如,笔者的 Azure Open AI 是不能直接选择使用模型的,而是使用模型创建一个部署,然后通过指定的部署使用模型,因此在 api 中不能直接指定使用 gpt-4-32k 这个模型,而是通过部署名称使用,在模型列表中选择可以使用的模型,而在模型重定向中设置部署的名称。

然后在令牌中,创建一个与 open ai 官方一致的 key 类型,外部可以通过使用这个 key,从 one-api 的 api 接口中,使用相关的 AI 模型。

one-api 的设计,相对于一个代理平台,我们可以通过后台接入自己账号的 AI 模型,然后创建二次代理的 key 给其他人使用,可以在里面配置每个账号、key 的额度。

创建令牌之后,点击复制,然后保存。

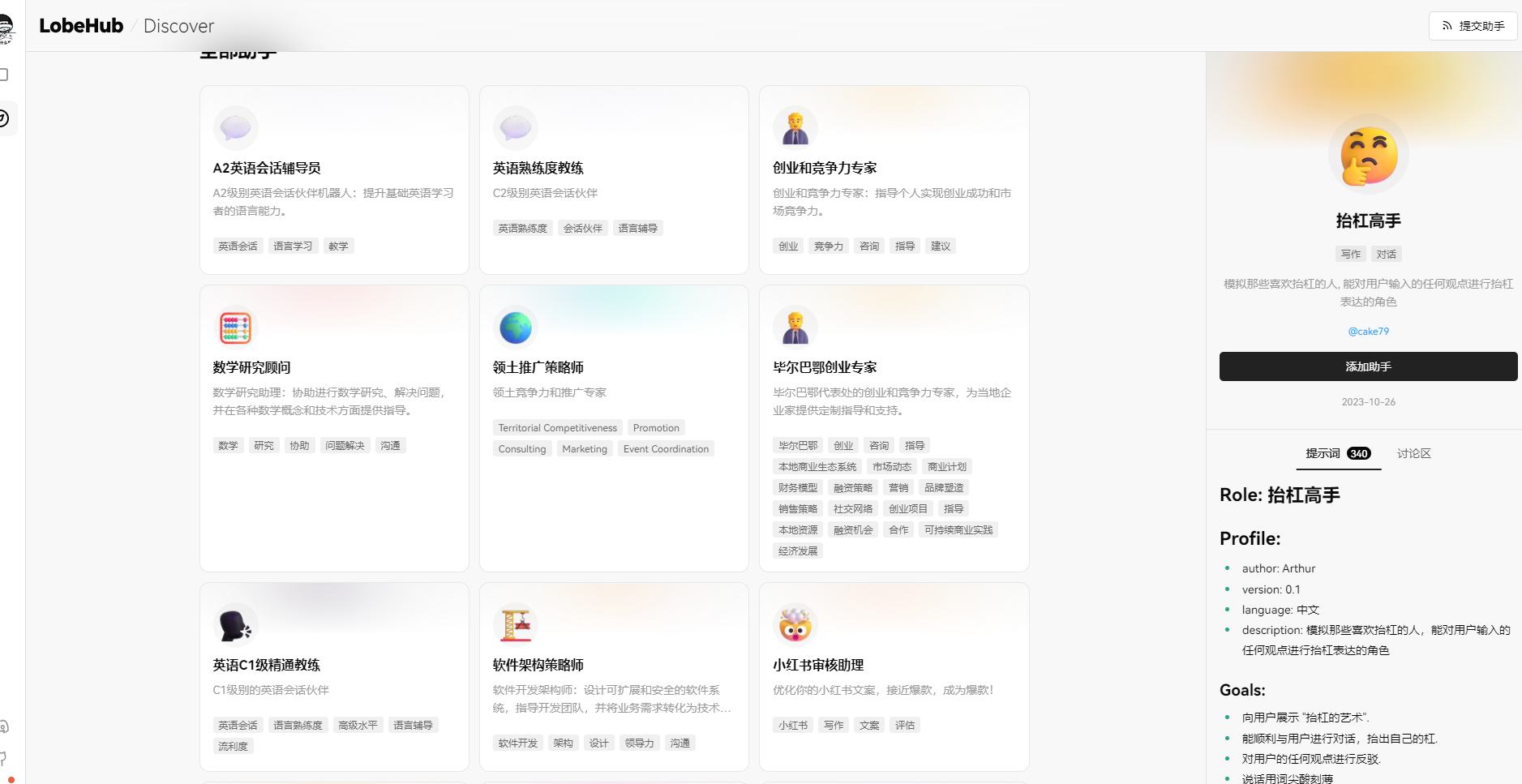

LobeChat

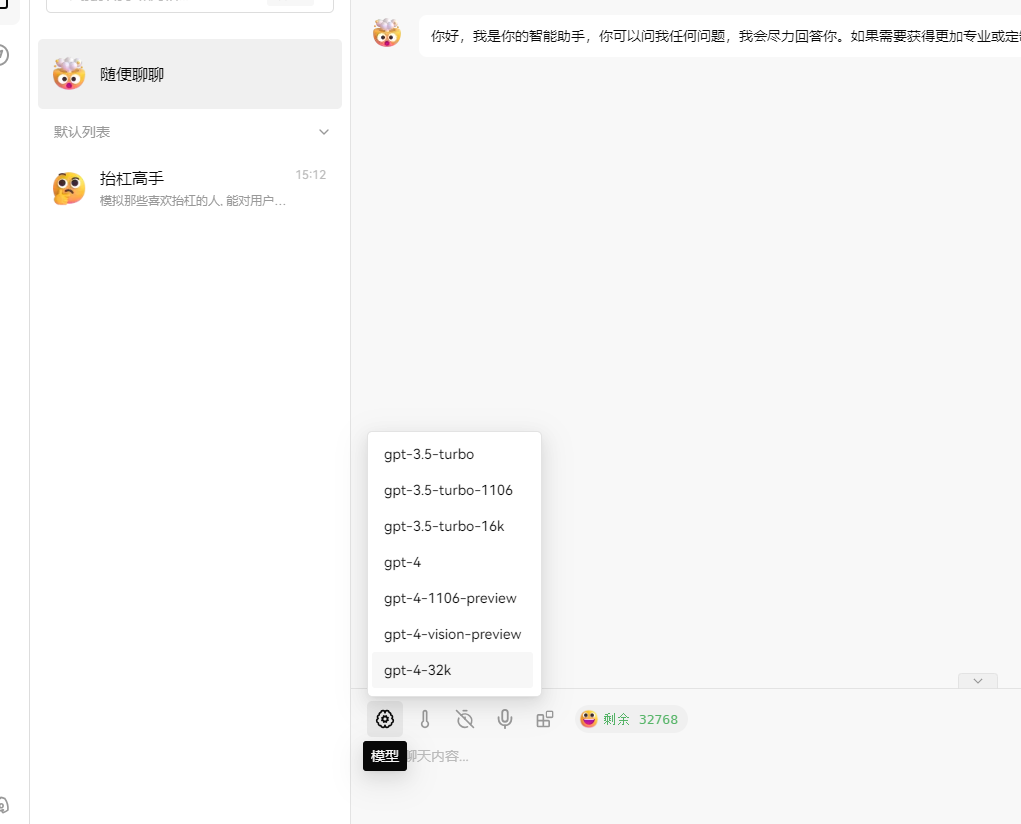

lobechat 是一个 webui 系统,使用前端技术编写,可以独立部署 web 服务,lobechat 支持 open ai、 azure open ai,有非常好看的 ui 界面,还支持语音输入、播放、图片处理等。

部署方法也很简单,直接使用 docker 部署即可。

docker run -d -p 3210:3210 \

-e OPENAI_API_KEY=sk-xxx \

-e BASE_URL=http://192.168.x.x:3000/ \

-e OPENAI_PROXY_URL=http://192.168.x.x:3000/v1 \

-e CUSTOM_MODELS=gpt-4-32k \

-e ACCESS_CODE=123456 \

--name lobe-chat \

lobehub/lobe-chatOPENAI_PROXY_URL 填写部署的 one-api 地址,后面一定要带个 v1。

OPENAI_API_KEY 填写密钥。

BASE_URL 可以不填,可以随意。

ACCESS_CODE 是访问密码。

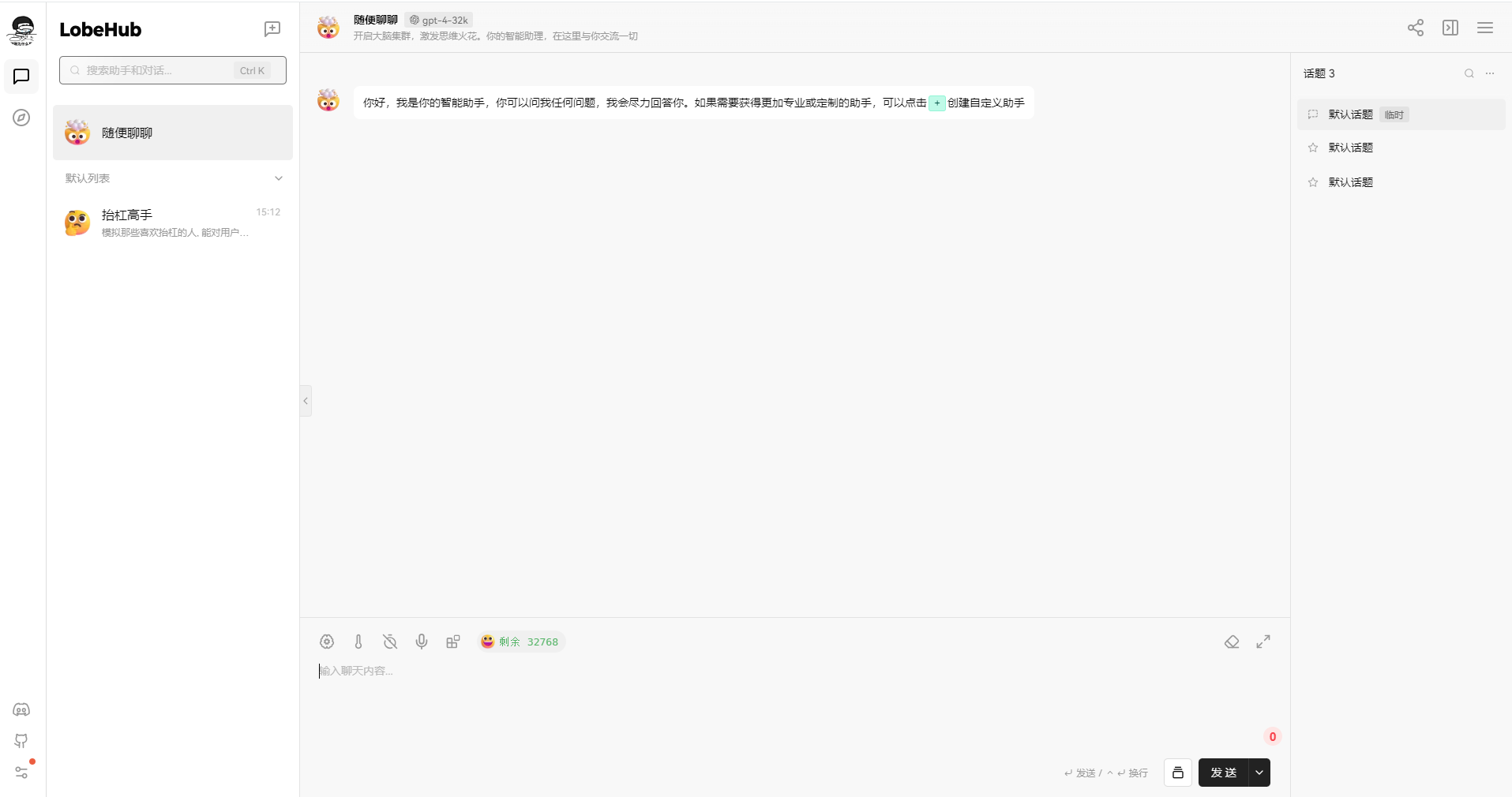

部署完成后,首先进入界面配置使用的 AI 模型。因为是个人账号,不一定都支持各种模型。

然后即可愉快地使用 AI 系统进行问答。

fastgpt

FastGPT 是一个基于 LLM 大语言模型的知识库问答系统,提供开箱即用的数据处理、模型调用等能力。非常适合企业内部使用。

主要应用场景有智能 AI 客服,可以训练问答数据替代人工回答用户问题;训练内部文档,使用 AI 回答各种业务问题、识别产品文档;自定义请求 httpapi 、问题分类等,可以在用户问答时使用后台 API 处理结果组合形式,例如用户询价;支持工作流编排等。

同时 fastgpt 有开放 api 接口,可以很方便地进行二开,做自己专属的客服系统等。

下载 fastgpt 的部署脚本:

mkdir fastgpt

cd fastgpt

curl -O https://raw.githubusercontent.com/labring/FastGPT/main/files/deploy/fastgpt/docker-compose.yml

curl -O https://raw.githubusercontent.com/labring/FastGPT/main/projects/app/data/config.json修改 docker-compose.yml 中的端口,因为 fastgpt 默认端口也是 3000 会导致冲突,同时可以修改密码,默认账号密码为 root、1234。

部署启动:

# 在 docker-compose.yml 同级目录下执行

docker-compose pull

docker-compose up -d详细使用方法可以参考官方文档:https://doc.fastgpt.in/docs/

文章评论